Как ИИ-боты атакуют сайты и что с этим делать разработчикам FOSS

Разное Март 28, 2025

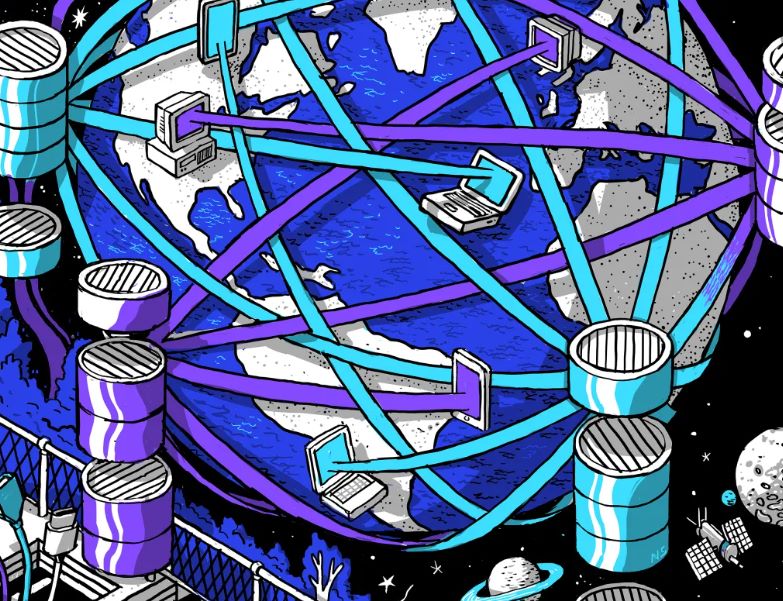

Знакомьтесь, краулеры — эти маленькие цифровые тараканы, которые могут превратить ваш сайт в руины. И особенно их страдают опенсорсные проекты. Почему? Потому что такие сайты часто открывают свои данные и хранят их в общедоступных репозиториях, но у них нет тех ресурсов, чтобы справиться с нападением огромного потока ботов.

Что делают эти боты? Они просто начинают соскабливать сайт. Всё, что угодно: данные, код, страницы — и всё это повторяется снова и снова. Бот будет кликать по каждой ссылке, открывать каждую страницу и делать это так долго, пока сервер не рухнет. Порой, из-за перегрузки запросами, возникает DDoS-атака — сайт просто «падает» под весом этих беспощадных запросов.

Многие из этих ботов не уважают robots.txt — тот самый файл, который разработчики используют, чтобы сказать: "Эй, боты, вот сюда не ходите!" Он был создан для того, чтобы поисковики знали, что можно индексировать, а что — нет. Но ИИ-боты просто не обращают на это внимания. Они прячутся за разными IP-адресами, притворяются другими пользователями, меняют свой user-agent (информация о браузере), чтобы выглядеть как обычные люди. Так что их не так-то просто поймать.

Xe Iaso, разработчик FOSS, столкнулся с этим и решил не сидеть сложа руки. Его сервер GitHub был атакован AmazonBot — ботом от Amazon, который без усталости пытался получить доступ к данным и вызывал перебои в работе сайта. Но самое интересное — он просто проигнорировал robots.txt, который Iaso специально настроил, чтобы ограничить доступ ботов. Этот бот использовал IP-адреса других пользователей и пытался маскироваться, чтобы избежать блокировки.

"Бесполезно блокировать ИИ-краулеров," — жалуется Iaso. "Они лгут, меняют user-agent, используют IP-прокси для обхода ограничений и могут атаковать до тех пор, пока сервер не упадет." И они не останавливаются: кликают по каждой ссылке на каждой странице, повторяя это снова и снова.

Чтобы хотя бы немного сдержать атаку, Iaso разработал Anubis — инструмент, который проверяет запросы и пропускает только человеческих пользователей, но блокирует ботов. Это проверка с использованием proof-of-work, когда бот должен выполнить задачу, прежде чем получить доступ к серверу. Если запрос успешен, появляется забавная анимированная картинка. Если это бот — отказ.

Идея с Anubis оказалась настолько популярной, что за несколько дней проект собрал 2,000 звезд на GitHub. Однако такой подход — далеко не единственный способ борьбы.

Некоторые разработчики, чтобы заставить ботов "потратить время зря", начали заполнять robots.txt страницы фейковым контентом. Например, страницы с материалами о вреде отбеливателя или прочими нелепыми вещами. Это должно отпугивать ботов, заставляя их терять ресурсы и не собирать полезную информацию.

Cloudflare, например, представила инструмент AI Labyrinth, который сбивает с толку ботов, вводя их в лабиринт ненужных данных. Это заставляет их тратить ресурсы и время на бесполезные запросы, а не на реальные данные сайта.

В общем, ИИ-боты продолжают атаковать, а разработчики FOSS на это отвечают — с хитростью, с иронией, и с целым набором инструментов для защиты своих ресурсов от этих цифровых паразитов. Ведь если не действовать, ваш сайт будет просто съеден этой армией краулеров.